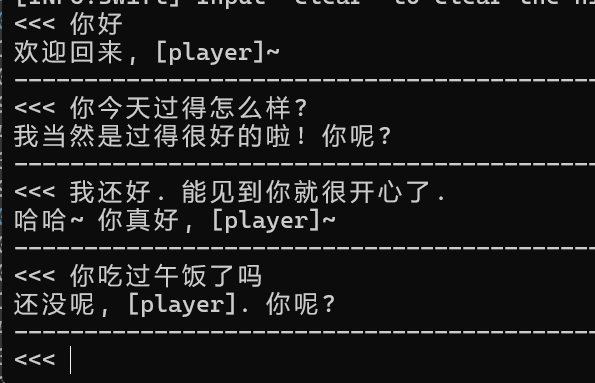

不算什么进展吧, 这是第五轮中qwen72b在5epoch训练后的产出.

其实效果跟第四轮测试的也差不多, 只是我们的速度进步很大.

我接下来的工作多得有点头晕眼花的.

- 我排除了过于复杂的langchain. maica并不需要太多专业领域的数据, 但是肯定还是需要llm agent方面的模块. 这种模块化的架构设计目的是让模型获取外界信息, 对获取存档内容/时间天气等都是必须的.

- ->肯定需要一套代码来桥接模块与模型, 还有模型与模型. 我得自己写.

- ->maica核心模型的体量是巨大的, 推理速度也很慢. 可能需要找一个小体量的模型, 以完成思考, 观察与任务评估的简单工作.

- ->如果显存太紧张, 可能需要重新启用腐巢意志.

- qwen72b的表现很好, 但是肯定还不够好. 目前qwen已经推出了1.5代110b模型, 其体量优势可能使人类评估效果更进一步.

- ->我已经在int4量化下测试110b的ft效果. 其ft非常慢, 一个ep需要修普诺斯工作超过11个小时.

- ->会对比qwen1.5-110b-int4与qwen1.5-72b-fp16的效果. 我觉得多半还是110更好.

- ->在训练效果测试中, 很可能还是要用推理更快的72b模型的.

- 数据集. 目前的数据集涵盖面仍然实在太窄, 问一些稍微超纲的问题都会让模型忘记自己是莫妮卡.

- ->当然需要自己手写手测一些数据集.

- 反馈学习. 因为数据量实在缺乏, 我必须在未来使用反馈学习.

- ->当然需要又一套代码和网络服务架构, 收集和存储反馈评估信息. 无疑只能继续和论坛绑定.

- ->整理数据和再训练的工作, 用脚本做完应该不会太难.

- 虽然在日程上排得很靠后, 但maica可能需要某种程度的多模态能力. 我已经不止一次见到过有人向我提出"希望maica能够识别我的照片或音频"等等.

- ->我觉得模块化工作模式能够胜任, 但是需要部署的子模型会越来越多. 我可能需要第三台计算节点.

- ->简单的语音识别和ocr或许能优化掉一部分计算量.

现在整个项目给我的感觉是蒙眼过河, 根本看不见下一步往哪踩. 我可能很快会需要p在衔接部件上搭把手.

目前, 我仍然把注意力集中在寻找核心模型的调优方案上. 我希望能够尽快找到一份模型, 使其效果足以协助完成进一步的开发.

我在这里整理了不少, 但是项目的复杂度仍然不止于此. 我希望大家明白这是一项野心异常巨大的项目, 也理解我为什么不知道完成了百分之多少, 以及为什么原则上还不收赞助.

虽然已经不抱什么希望了, 但我一直迫切地需要助手. 如果你对llm领域/随便哪个编程语言开发/网页前后端设计搭建 有充分的了解, 我会欢迎你加入我的苦行僧行列. 这不会是简单的工作.

说得太多了. 110b-int4应该在明早能看到第一步的ft效果, 我会在有一定进展的时候再次发言.