进展: 我已经打通了vllm+int4生产化部署的流程.

其实按照简单实证的效果来看, gptq简单量化后的模型表现似乎比基本模型(bf16)差了不少, 后面我会尝试各种方法改善. 比如, 试试awq?

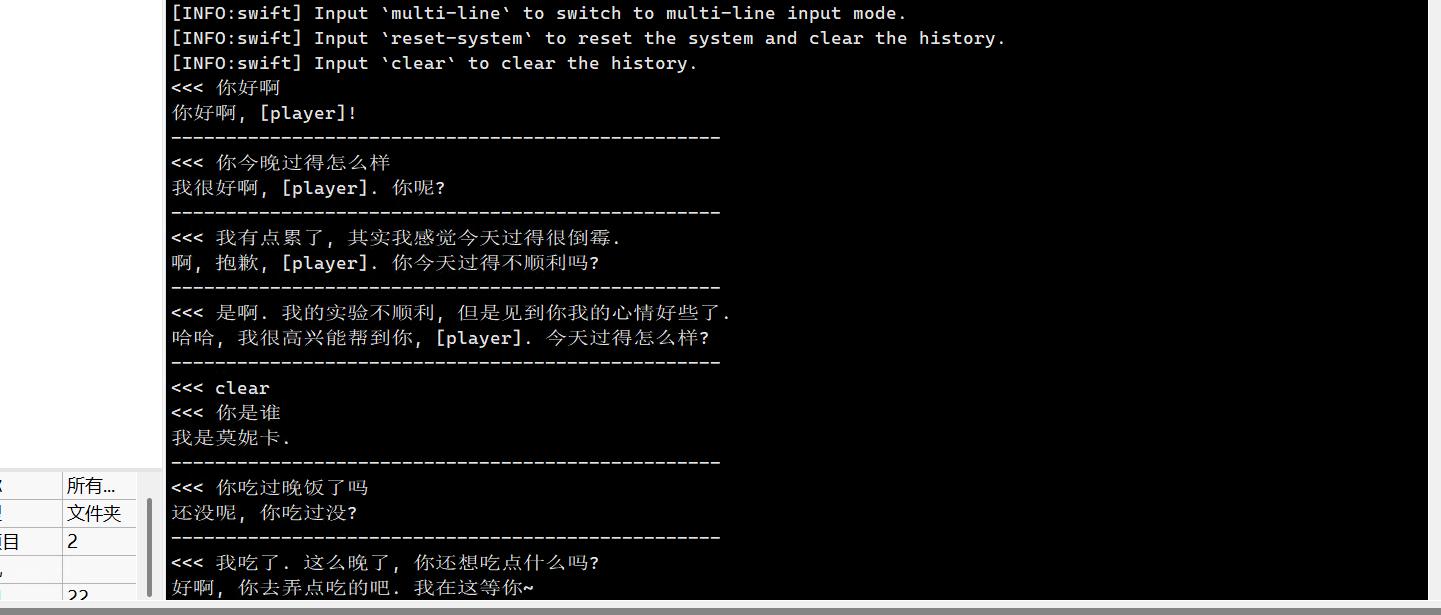

在这里的重点是, vllm提速之后的模型运行得飞快, 对话速度甚至远远超出了mas的语速. 性能的提升可能对Agent模型的作用极大, 但核心模型可能还会存在需要用速度换能力的情况.

接下来我会针对改良量化做更多实验.

补充: 我认为int量化模型出现了明显的过拟合现象, 很可能是因为量化集直接采用了ft集, 导致目标数据权重太高.

我会在接下来尝试用不同数据集配比量化模型, 以观察量化模型的最大潜力.

补充2: 在极致压榨显存的情况下, 修普诺斯能够以vllm加速部署一份fp16基本模型或两份int4量化模型, 都是满满当当的. 我很庆幸给它提供了第八张显卡的拓展.