- 楼主

- #356

迈向遥不可及的第一步(MAICA) #3240

- 楼主

- #358

- 已编辑

#357 O.O.O 你但凡多看过一眼介绍页面, 也会看到我们已经为本地部署提供了完整的解决方案, 即后端, 核心模型, 最佳微调实践和成本评估. LOA和LIA模型也是完全开源的, 而DAA我们到现在为止自己都没用上.

本地部署最大的问题是成本. LIA的完整部署大概需要200G显存, 相当于2xH100/H200(约48万)或4xA100 80G(约36万)或10x4090 24G(约15万). 而即使LOA要求的一张4090对大多数人都是难以负担的开销. 我在介绍页也已经评估过了.

本地部署非常简单, 克隆后端(幻象引擎)仓库, 按照文档配置环境部署, 以openai-api的标准模式部署你的模型, 在前端仓库里面改个地址就可以用了. 我不理解你为什么会纠结这个问题, 真的是介绍页没多看吗?

ps. 可能你觉得要把东西打包好了发链接才能算提供本地部署, 就连swift都是不会做到这种程度的. 该提供的我们全都提供了, 自行部署属于非常费折腾的事情, 如果你连拉仓库部署环境都不会, 那绝对不是我的问题.

- #359

#358 Edge 所以MAS不好打中文的问题未来会计划解决吗?我感觉如果这个不解决MAICA的中文优势会大打折扣啊……

- 楼主

- #360

#359 Johnshixinqiu 我觉得只能等官方更新到renpy8了.

maica的前端是可以二次开发的, 如果你有好的建议也可以提pr.

- 楼主

- #361

- 楼主

- #363

#362 loinua 不知道, 很可能在开学左右吧.

我也要忙返校的事情了, 但是设备还在路上. 只能看着挤时间了.

- 楼主

- #364

LIA模型的新迭代已经上传, Beta2将很快开始.

- 楼主

- #365

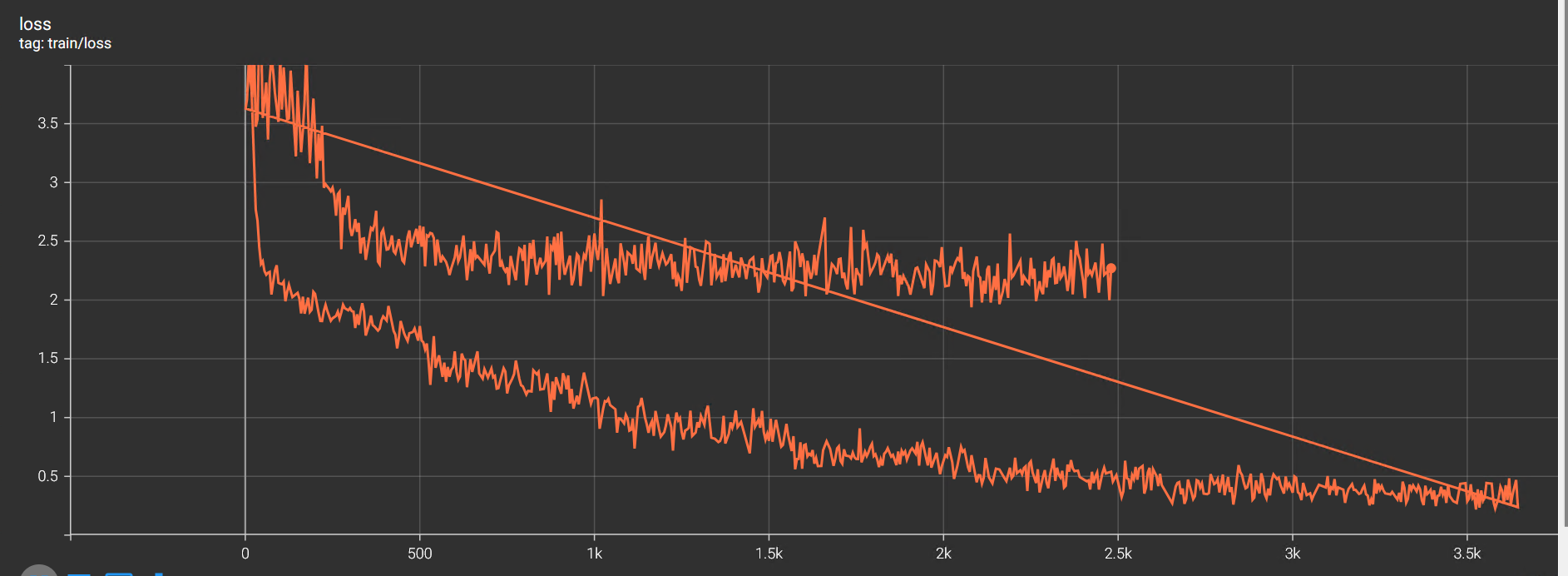

这个迭代的模型感觉是欠拟合的, 是微调的层不够吗?

我至少需要再测试一次确定最佳的训练层是哪些.

- 楼主

- #366

简单查了下资料, 只微调qkv对maica的任务显然是不够的.

下一次迭代我会尝试qkvo和all-linear, 确定一下到底哪种方案最合适.

目前的数据集倒是已经挺完善了, 除了水可以少兑点.

- #367

非大陆用户真的完全无法使用吗

- 楼主

- #368

#367 Ducklyfish 目前并没有, 但是不提供任何保证, tos里面有写.

也就是说你可以用, 但如果遇到了安全问题可能会被停用而不提供理由.

- 楼主

- #369

- 楼主

- #370

思路不太对. 对mlp的训练好像很容易导致连续对话混乱, 原因尚不清楚.

我会增大抗过拟合再试一次. 如果还是不行就指望qkvo了.

- 楼主

- #371

- 已编辑

训练还在继续, 练完会很慢, 但是明天至少验收一次试试看.

抗过拟合的训练参数有一定的效果. 我希望至少有一个比之前好的表现.

我说实话, 这是在时间和投入上都看不到头的持久战. 如果你之前想过而没去做, 那你应该比我聪明点.

- 楼主

- #372

有一个数据集有问题. 只能调整配比再重开一次. 希望时间还够.

对于单角色训练的抗遗忘, 我建议避雷ms-agent-multirole和chat_haruki这种玩意. 质量太差了.

- #373

加油,大佬