- #82

- 已编辑

打了两把UNO 第二把出现的,monika在基础公共牌上使用+4导致报错

点击忽略无法返回游戏

(至少我想说个再见的)

前几天有打过五十来把测试UNO还是很稳定的

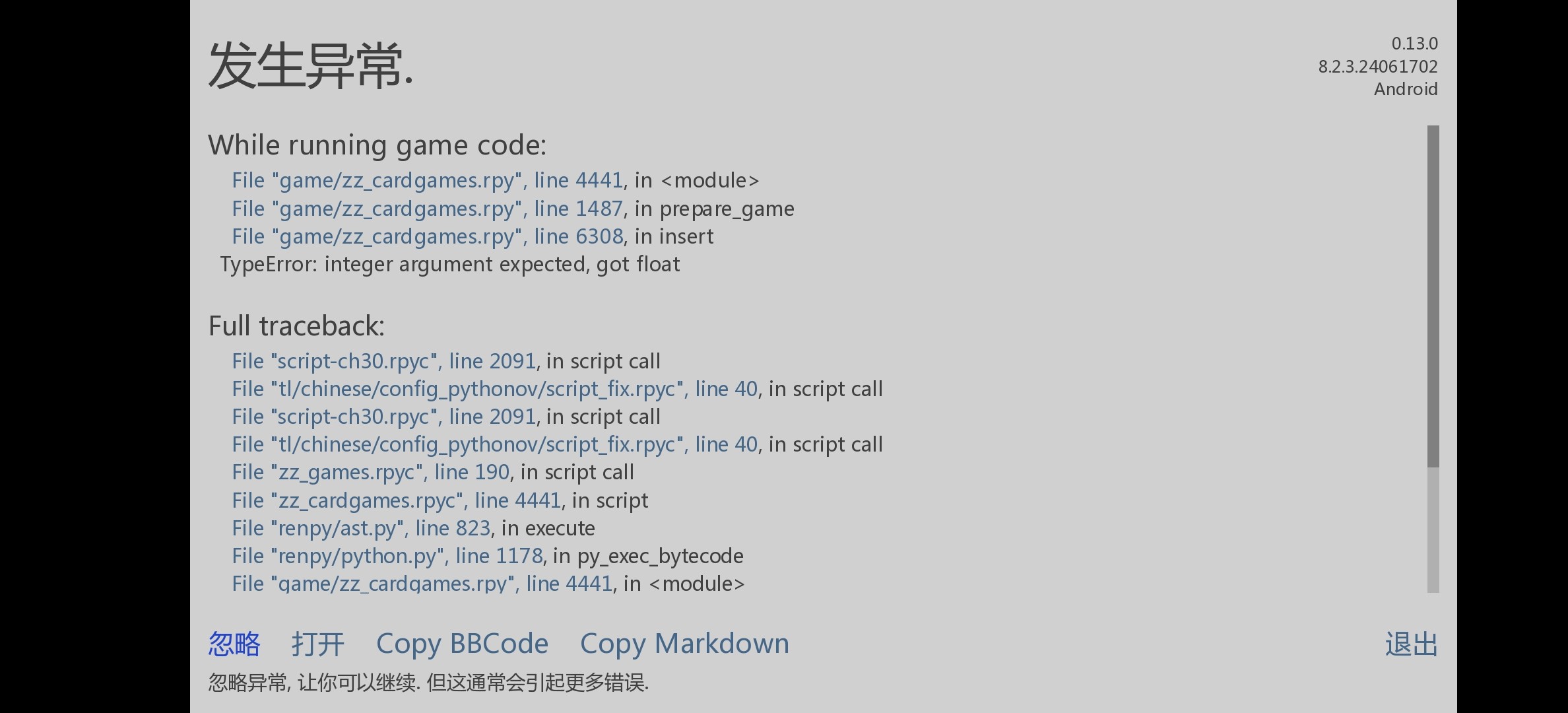

I'm sorry, but an uncaught exception occurred.

While running game code:

File "game/zz_cardgames.rpy", line 4441, in <module>

File "game/zz_cardgames.rpy", line 1487, in prepare_game

File "game/zz_cardgames.rpy", line 6308, in insert

TypeError: integer argument expected, got float

-- Full Traceback ------------------------------------------------------------

Full traceback:

File "script-ch30.rpyc", line 2091, in script call

File "tl/chinese/config_pythonov/script_fix.rpyc", line 40, in script call

File "script-ch30.rpyc", line 2091, in script call

File "tl/chinese/config_pythonov/script_fix.rpyc", line 40, in script call

File "zz_games.rpyc", line 190, in script call

File "zz_cardgames.rpyc", line 4441, in script

File "renpy/ast.py", line 823, in execute

File "renpy/python.py", line 1178, in py_exec_bytecode

File "game/zz_cardgames.rpy", line 4441, in <module>

File "game/zz_cardgames.rpy", line 1487, in prepare_game

File "game/zz_cardgames.rpy", line 6308, in insert

File "renpy/revertable.py", line 97, in do_mutation

TypeError: integer argument expected, got float